Kurze Zusammenfassung

Dieses Video behandelt die Auswirkungen von DeepSeeks neuem Open-Source-Sprachmodell R1 auf die KI-Landschaft. Es zeigt, dass R1 OpenAIs Modelle in vielen Metriken übertrifft, und das mit deutlich weniger Ressourcen. Das Video untersucht auch die Möglichkeiten, R1 auf verschiedenen Geräten, einschließlich Raspberry Pi und einem 192-Kern-Server, auszuführen. Es wird festgestellt, dass selbst ein Raspberry Pi mit einer dedizierten Grafikkarte R1 mit einer akzeptablen Geschwindigkeit ausführen kann. Schließlich wird die anhaltende Euphorie um KI angesprochen und die Notwendigkeit, die Ressourcen für KI-Entwicklung effizienter zu nutzen, betont.

- DeepSeeks R1 übertrifft OpenAIs Modelle mit weniger Ressourcen.

- R1 kann auf verschiedenen Geräten, einschließlich Raspberry Pi, ausgeführt werden.

- Die KI-Euphorie ist ungebrochen, aber es besteht Bedarf an effizienterer Ressourcennutzung.

OpenAIs Albtraum

Das Video beginnt mit der Vorstellung von DeepSeeks neuem Open-Source-Sprachmodell R1, das OpenAIs Modelle in vielen Metriken übertrifft. DeepSeek konnte R1 mit nur 6 Millionen Dollar und GPUs mit halber Bandbreite von OpenAIs Modellen entwickeln. Dies stellt eine große Bedrohung für OpenAI dar, da es zeigt, dass leistungsstarke KI-Modelle mit deutlich weniger Ressourcen entwickelt werden können.

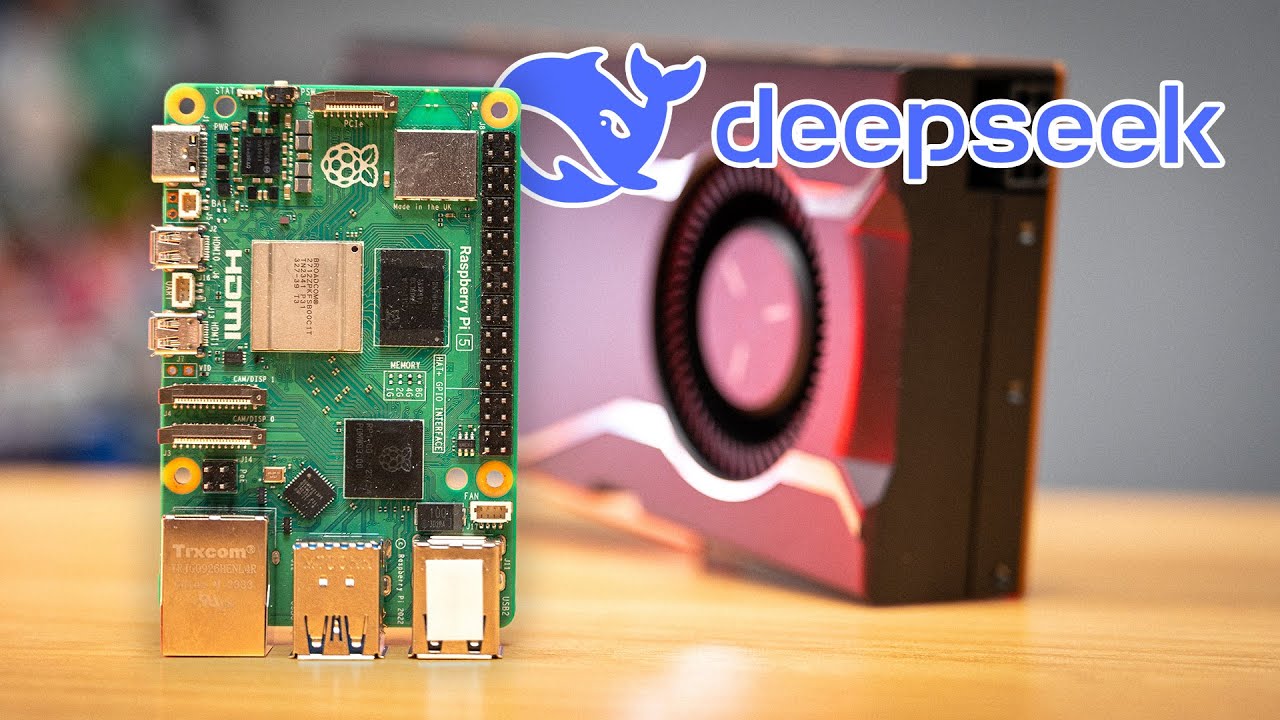

Was kann ein Pi 5 wirklich?

Der Autor erklärt, dass ein Raspberry Pi 5 zwar technisch DeepSeeks R1 ausführen kann, dies aber nicht mit der gleichen Leistung wie auf einem leistungsstärkeren System geschieht. Er betont, dass das 671B-Modell, das ChatGPT übertrifft, immer noch eine erhebliche Rechenleistung erfordert.

671b auf AmpereOne

Der Autor demonstriert die Ausführung von DeepSeeks 671B-Modell auf einem 192-Kern-Server. Obwohl die Geschwindigkeit mit 4 Token pro Sekunde nicht besonders hoch ist, ist der Server im Vergleich zu anderen High-End-Systemen relativ günstig und energieeffizient.

Pi 5 14b - CPU-Inferenz

Der Autor testet die Ausführung des 14B-Modells von R1 auf einem Raspberry Pi 5. Die Geschwindigkeit ist mit 1,2 Token pro Sekunde sehr langsam, aber ausreichend für einfache Aufgaben wie Rubber-Duck-Debugging oder das Generieren von Ideen.

Pi 5 14b - GPU-Inferenz

Der Autor zeigt, dass die Verwendung einer externen Grafikkarte die Geschwindigkeit des 14B-Modells auf einem Raspberry Pi 5 deutlich erhöht. Mit einer AMD W 7700 Grafikkarte erreicht er eine Geschwindigkeit von 20 bis 50 Token pro Sekunde.

GPUs auf Pi (und das Jahr des Arm-PCs)

Der Autor diskutiert die wachsende Verfügbarkeit von GPUs für ARM-basierte Geräte wie den Raspberry Pi. Er erwähnt, dass sowohl AMD als auch Intel Open-Source-Treiber für ihre GPUs auf ARM-Plattformen anbieten, und dass Nvidia möglicherweise bald folgen wird.

Immer noch in einer KI-Blase

Der Autor spricht die anhaltende Euphorie um KI an und die Tatsache, dass Nvidia trotz des Aufkommens von DeepSeek einen erheblichen Wertverlust erlitten hat. Er argumentiert, dass die KI-Industrie möglicherweise zu viel Ressourcen für die Entwicklung von Modellen verwendet, die nicht unbedingt notwendig sind. Er betont die Notwendigkeit, die Ressourcen effizienter zu nutzen und die KI-Entwicklung auf sinnvolle Anwendungen zu konzentrieren.